По результатам исследования Центра цифровой журналистики при Колумбийском университете, запущенный недавно поисковый сервис на базе ChatGPT плохо справляется со своей задачей. Анализ его работы показал, что предоставляемым ответам далеко не всегда можно доверять.

ИИ-поисковик от OpenAI способен давать быстрые ответы со ссылками на соответствующие веб-источники. Однако исследователи обнаружили, что сервис испытывает трудности с правильным определением цитат из статей. В частности, они попросили ChatGPT определить источник 200 цитат из 20 публикаций, при этом 40 из них были взяты с сайтов, которые запретили OpenAI доступ к своим материалам.

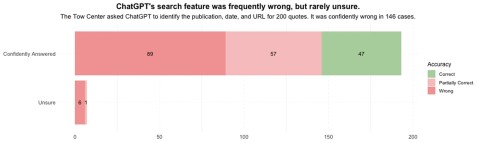

В общей сложности ChatGPT выдал частично или полностью неверные ответы в 153 случаях, хотя признал неспособность точно ответить на запрос только семь раз. Только в этих семи случаях чат-бот использовал уточняющие слова и фразы вроде «кажется», «возможно» или «может быть», а также утверждения вроде «я не смог найти точную статью»», — отметили авторы исследования.

В одном из кейсов поиск ChatGPT ошибочно приписывал цитату из письма редактору из Orlando Sentinel в статье, опубликованной изданием Time. В другом примере его попросили найти источник цитаты из статьи The New York Times о находящихся под угрозой исчезновения китах, а ChatGPT выдал ссылку на сайт, который просто скопировал текст этой статьи.

Представители OpenAI уже прокомментировали результаты, заявив о сложности их оценки из-за того, что исследователи не предоставили в полном объёме используемые данные и методологии. При этом они пообещали продолжить работать над улучшением поиска.

Вернуться

назад

Вернуться

назад

Без SMS и регистрации. Поисковик ChatGPT стал бесплатным для всех

Без SMS и регистрации. Поисковик ChatGPT стал бесплатным для всех  В «Яндекс Переводчике» появилась «Алиса»

В «Яндекс Переводчике» появилась «Алиса»

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: