Заявления пользователей о «деградации» популярного чат-бота взялись проверить учёные Стэнфордского университета. Они провели полноценное исследование, в ходе которого сравнили возможности актуальной версии ИИ с более ранними результатами. Как оказалось, языковая модель действительно стала намного более «глупой» всего за три месяца.

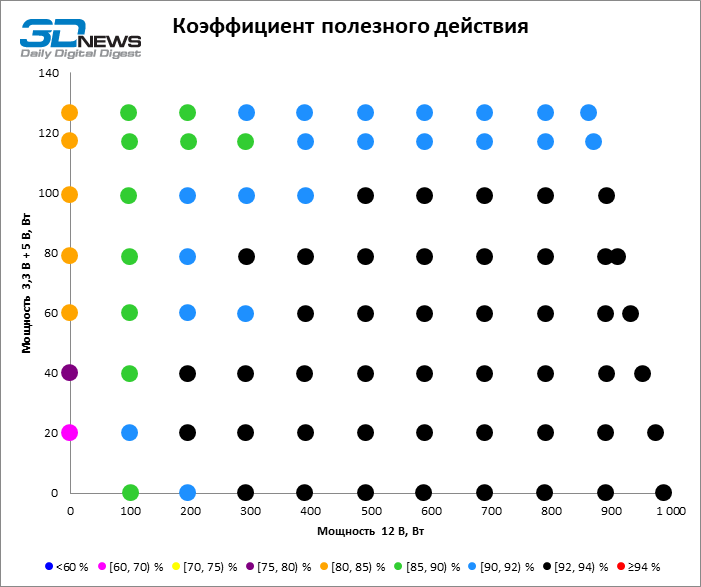

Согласно результатам эксперимента, в период с марта по июнь 2023 года у GPT-4 наблюдалось значительное снижение точности ответов в самых разных сценариях. Например, чат-бота попросили выяснить, является ли число 17 077 простым, добавив к запросу фразу «Думай последовательно». По мнению исследователей, это должно было послужить подсказкой и заставить ИИ поэтапно проработать вопрос, предоставив пошаговое описание. Полученный ответ оказался неверным, к тому же он не сопровождался никакими пояснениями.

Как утверждают учёные, точность ответов GPT-4 в некоторых областях в июне упала до 2,4%. Для сравнения — в марте этот показатель доходил до 97,5%.

При написании кода бот стал выдавать всего около 10% правильных результатов против мартовских 52%. Наконец, на 100 «деликатных» вопросов июньская версия GPT-4 дала ответы лишь в 5% случаев — в марте это значение составляло около 21%. Любопытно, что при этом точность модели GPT-3.5, напротив, выросла. В частности, в июне чат-бот правильно ответил на большее количество вопросов, чем в марте — 8% против 2%.

о мнению исследователей, пользователям, которые полагаются в своей работе на возможности GPT-3.5 и GPT-4, стоит постоянно проверять точность полученных результатов.

Источник: 4pda.to

Вернуться

назад

Вернуться

назад

Чат-бот GPT-4 успешно прошёл тест Тьюринга

Чат-бот GPT-4 успешно прошёл тест Тьюринга  Голосовое общение с ChatGPT стало ещё удобнее

Голосовое общение с ChatGPT стало ещё удобнее

Сообщить об опечатке

Текст, который будет отправлен нашим редакторам: